一、生成式AI的雙面刃

生成式人工智慧(generative AI)的急速發展,已逐漸開始對社會、經濟和科學進步產生影響。構成生成式AI的技術要素之一為大型語言模型(large language model, LLM),通常包含數量巨大(數十億甚至上千億)的輸入參數,再經過研究人員訓練後,使得這些LLM能夠執行以前電腦所無法處理的複雜任務,比如自然語言處理、圖像生成和資料分析,也被部分科學家稱為基礎模型(foundational model),以顯示它們在AI技術發展上的重要性[1]。

然而在近幾年以前,LLM仍大多屬於封閉式或高度受限的狀態,除了開發和擁有模型的人以外,其他人無法直接存取LLM或利用其程式碼並了解LLM的運作方式,而僅能透過由開發者創造的應用程式介面利用這類生成式AI。不過隨著科技企業、計算機科學家、資訊工程師等社群的努力,近年LLM逐漸朝向日益開放的生態系發展,使開發者和其他人員能夠利用計算機運算資源「微調」(fine-tune)模型,從而使LLM符合開發者設定的使用目的和需求,稱為開放式基礎模型(open foundational model)[2]。

由於其開放性,開放式基礎模型有助於小型企業、學術機構、資金不足的企業家,以及傳統企業能夠運用AI技術創新和推進科學知識,亦即這類模型能夠促進與普及AI為人類帶來的好處[3]。然而開放式基礎模型如被濫用、缺乏監管、監管失靈或缺乏課責機制也可能產生重大的安全、公平和公民權利受損的風險。比如惡意行為者可能利用開放式基礎模型的廣泛可用性和訓練資料集的相似性,開發出專門的攻擊方式。隨著微調模型所需的運算量減少,惡意行為者利用模型實施攻擊的機會也會增加。更不用說,LLM能夠合成圖片、影像和語音,在基於錯誤訓練方式的情況下可能產生錯誤或虛假資訊,稱為AI幻覺(hallucination),從而擾亂社會和政治穩定[4]。

二、拜登AI行政命令預先因應生成式AI爆發式成長的前景

拜登於2023年10月30日簽署《人工智慧安全、可靠和可信發展與使用的行政命令》(Executive Order of Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence,下稱AI EO),旨在應對AI技術的國安風險[5]。AI EO涉及聯邦政府研發、使用、管理與部署人工智慧的各方面要求,具體要求多達150項,並分別設定90日、180日、270日、360日以及600日的規定落實期限[6]。

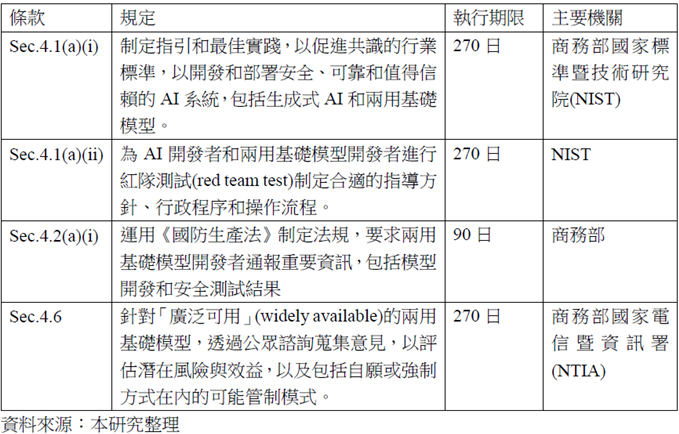

針對開放式基礎模型,AI EO稱為兩用基礎模型(dual-use foundational models)。AI EO指出兩用基礎模型可能產生的具體風險,包括:大幅降低化學、生物、放射性或核武(CBRN)的研發與使用進入門檻(因此增加發生恐怖攻擊的機率);使用自動化措施發現並利用各種網路漏洞,實施網路攻擊;以及使用欺騙或混淆手段逃避人類控制或監督(因此可能產生錯誤資訊造成經濟和金融混亂)。簡言之,兩用基礎模型對於美國的國家安全、經濟安全、公共衛生安全,或三者之組合,可能構成潛在的嚴重風險[7]。拜登要求商務部長需在一定期限採取行動,包括制定管制性法規以及進行深入研究等,對兩用基礎模型實施合理管理(相關規定如下表)。

此外,由於訓練AI模型所需運算能力約每10個月成長一倍[8],AI EO也授權商務部長應定期與其他機關首長討論需受到管制AI模型的技術門檻。AI EO規定,若兩用基礎模型的開發者或擁有者可能取得大規模運算叢集(large-scale computing cluster),即應向商務部通報。大規模運算叢集分為兩類:一種是使用大於10的26次方整數或浮點數運算(floating-point operations)的能力訓練AI模型,或主要使用生物序列資料(biological sequence data)且使用大於10的23次方運算能力訓練AI模型;另一種是,位於單一資料中心的運算叢集(其中只要有任一組電腦放置於該資料中心即視為符合),若資料傳輸速率超過每秒100Gbits,且其訓練AI模型的運算能力之理論最大值達每秒10的20次方[9]。不過目前市場上的所有大型語言模型,皆還未達到前述門檻。

三、基於「去風險」限制中國大陸AI技術進展

在未來10年是美中進行戰略競爭的背景之下,當前美國國家安全戰略大方向是從去風險(de-risking)的角度,處理與中國大陸緊密的經貿來往。觀察美國作為,去風險策略落實在產業面,至少有三種因應方式。首先,對於具有高度軍事和國防安全意涵的產業嚴格管制,這類產業包括半導體和人工智慧、量子運算、生物科技,這也被政策分析師以及國安顧問蘇利文用「小院高牆」(small yard, high fence)加以形容﹔其次是相對關鍵的關鍵礦物、電動車、太陽能等,如何透過轉移市場和找尋替代來源﹔第三層則是其他產業,可照常與中國大陸來往[10]。

由於AI普遍視為改變國際格局的重大新興技術,AI EO也有授權商務部長應盡速訂定規範加以管理。近來美國政府也開始打算改變AI模型不受控制的現況。外電報導商務部產業及安全局(Bureau of Industry and Security, BIS)刻正研議出口管制法規,限制中國大陸獲取支持應用如ChatGPT的AI軟體[11],以及美國國會議員提出法案限制軍事用AI出口[12]。這些措施皆是其去風險策略的重要組成部分,防止中國大陸在軍事和技術領域獲得競爭優勢,確保美國在全球科技競爭中的領先地位。

不過美國若要對AI技術和兩用基礎模型使用出口管制工具,則有執法上的挑戰需克服。主要原因在於,根據《出口管制規則》(export administration regulation, EAR 99),AI非屬單一可受管制的類別,AI模型開發者也無需依法申請出口許可證。主管機關BIS主要從各種有助於促進AI發展的其他產業面向,對AI技術和產業加以管理,比如:積體電路/半導體;用於設計、開發、調整或將AI功能嵌入產品或平台的技術;用於AI功能的積體電路/半導體的製造設備等[13]。

前述規定若能成功制定且有效實施,也可能是繼2022年、2023年的半導體出口限制令之後,進一步確保美國「盡可能領先」中國大陸的具體措施。此舉同樣可能面臨美國企業反對,以及成為加速中國大陸自主科技研發的趨動力。儘管如此,目前美國企業仍未達到AI EO設定的技術門檻,因此BIS的法規將如何設計,包括是否於EAR 99新增專屬於AI的出口管制分類號(Export Control Classification Number, ECCN),或者在現行ECCN架構下增加屬於兩用基礎模型的技術參數描述,並加以管理,以及管制強度皆為後續可持續觀察的重點。

四、競爭並保留合作的可能性

除了繼續觀察美國使用出口管制等貿易工具限制中國大陸的科技進展,也須注意美中潛在合作的面向。2023年11月,拜登與習近平會面後承諾將共同研議人工智慧合作。美國和中國大陸雙方國安官員於今年5月14日在瑞士召開美中首次「人工智慧風險及安全對談」(U.S.-PRC Talks on AI Risk and Safety),就兩國政府理解和尋求解決先進AI系統風險交換意見。雖然會前與會後,包括兩國政府和各界皆不認為該對談有實質進展。不過在美中關係日趨冷淡的情形下,就重要議題開始對話本身已足以顯示兩國將AI發展視為需要共同處理的重要議題。在聯合國開始倡議將AI技術類比為核子武器而需加以管理的情況下,世界前二AI強國持續保持對話,以確保在AI發展與應用能夠共同尋找平衡點與管理風險,並推動技術的健康發展,不但是美中保留開展合作的關鍵,也是促進全球經濟穩定發展的重要因素。

[1] Helen Toner, What Are Generative AI, Large Language Models, and Foundation Models? May 12, 2023,

Center for Security and Emerging Technology(CSET), https://cset.georgetown.edu/article/what-are-generative-ai-large-language-models-and-foundation-models/ .

[2] National Telecommunications and Information Administration, Dual Use Foundation Artificial Intelligence Models With Widely Available Model Weights, April 26, 2024, Federal Register, https://www.federalregister.gov/documents/2024/02/26/2024-03763/dual-use-foundation-artificial-intelligence-models-with-widely-available-model-weights#citation-2-p14060

[3] Id.

[4] Id.

[5] Executive Order 14110 of October 30, 2023.

[6] Caroline Meinhardt, Christie M. Lawrence, Lindsey A. Gailmard, Daniel Zhang, Rishi Bommasani, Rohini Kosoglu, Peter Henderson, Russell Wald, Daniel E. Ho, By the Numbers: Tracking The AI Executive Order, November 16, 2023, https://hai.stanford.edu/news/numbers-tracking-ai-executive-order .

[7] AI E.O, Sec.3(k).

[8] Paul Scharre, Vivek Chilukuri, Tim Fist, Bill Drexel, Josh Wallin, Hannah Kelley, Sam Howell, Michael Depp, and Caleb Withers, NOTEWORTHY: Executive Order on the Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence, November 2 2023, https://www.cnas.org/press/noteworthy/noteworthy-executive-order-on-the-safe-secure-and-trustworthy-development-and-use-of-artificial-intelligence .

[9] AI EO, Sec.4.2(b).

[10] 參考Emily Benson and Gloria Sicilia, A Closer Look at De-risking, December 20, 2023, CSIS, https://www.csis.org/analysis/closer-look-de-risking ; 田習如,歐盟經濟安全 李淳建議參考台灣經驗且勿對台去風險,2024/1/31,中央社,https://www.cna.com.tw/news/aopl/202401310005.aspx。

[11] https://www.reuters.com/technology/us-eyes-curbs-chinas-access-ai-software-behind-apps-like-chatgpt-2024-05-08/

[12] https://www.reuters.com/technology/us-lawmakers-unveil-bill-make-it-easier-restrict-exports-ai-models-2024-05-10/

[13] https://www.morganlewis.com/pubs/2024/04/existing-and-proposed-federal-ai-regulation-in-the-united-states